Comunidade Experience – 3° DIA

Publicado em 6 de julho de 2022 – Samara Teixeira

O Terceiro dia do evento Comunidade Experience e mais duas lives “para a conta”. Tendo a presença marcante de dois incríveis profissionais nesse terceiro dia de evento, conseguimos dizer que chegamos na metade da primeira semana de evento. “Ah, mas o que é o Comunidade Experience?” pois se não sabia, agora vai ficar sabendo: nossa querida Comunidade de Estatística comemorou seus primeiros três anos de muito network, aprendizado e diversão, e para isso fizemos um evento de 15 dias de lives – e contamos com nossos colaboradores, parceiros, amigos e alunos para serem as grandes estrelas das palestras.

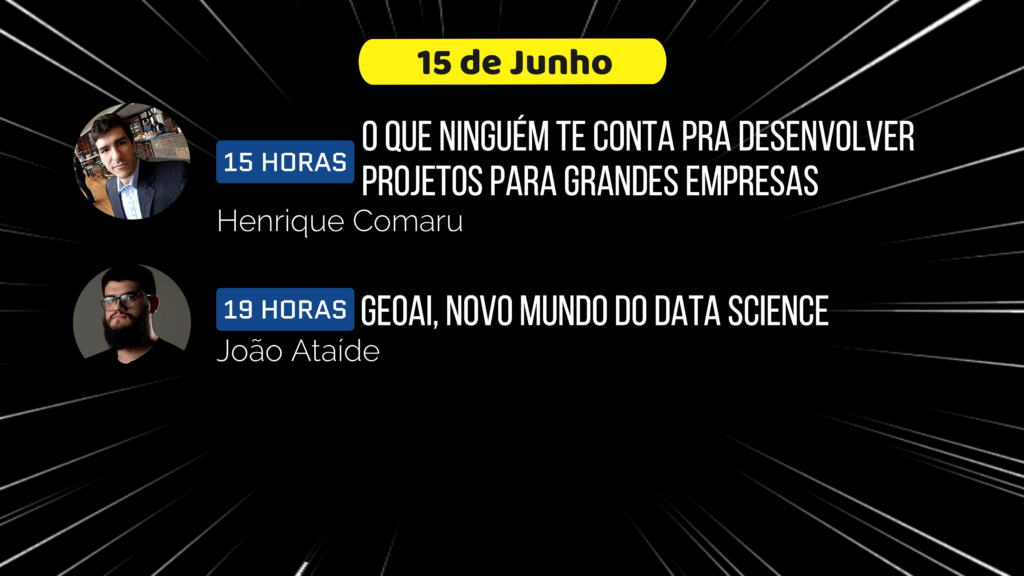

No dia 15/06 contamos com a presença do mestre Henrique Comaru na live das 15:00 e com o mestre João Ataíde na live das 19:00; dois queridos da Comunidade. Falando um pouco sobre eles, respectivamente, podemos falar sobre o currículo do mestre Comaru utilizando as palavras do próprio: “Formado em administração e especialista em gestão comercial. Consultor independente de BI, Desenvolvedor BI Sênior na Ambev Tech atuando também administrador de capacity de PowerBI para supply na América do Sul, Professor de BI e Data Viz em MBAs de algumas faculdades como USP, BSBr, UVV e Faesa.”

Trazendo agora o currículo do mestre João, podemos pontar as seguntes formações: pesquisador, especialista em geoprocessamento, data scientist e engenheiro de visão computacional. E como alguns de seus projetos desenvolvidos, temos diversos modelos estatísticos, probabilísticos e preditivos, outros nas áreas de de machine learning, deep learning, e contando sempre com ênfase nos dados espaciais, tendo foco na incorporação da inteligência geográfica na solução de problemas de negócios.

Partindo agora para falar sobre a primeira live do dia, a do mestre Comaru, onde o tema abordado foi “Power BI: O que ninguém te conta pra desenvolver projetos para grandes empresas” e no início contamos com um breve resumo do mestre Thiago, o host da nossa live, sobre o que rolou no dia anterior e também temos um artigo resumindo esse dia aqui no LinkedIn. Após isso, rolou a apresentação do nosso palestrante.

Começando a parte do conteúdo da live, o mestre Comaru traz a seguinte questão: Por que Power BI?, e respondendo: com essa ferramenta, há a possibilidade de uma “divulgação de informação muito grande” quando se conta com um ambiente premium e com a CAPACITY, nesse momento há a exibição dos prós e contras da contratação desse pacote. Após isso, é apontada a importância do uso para as empresas e é alegado que o aumento da demanda é progressivo com o tempo, então acaba por ser um investimento a longo prazo. Algumas das dicas do momento são: 1) não imputar os dados de qualquer forma, 2) não modelar os dados de qualquer jeito; além dessas ainda houveram outras.

O próximo ponto a se atentar em uma empresa de larga escala é a modelagem, aqui o mestre Henrique aponta a Star-Chema, ou modelagem dimensional, pois com ela há um aumento de performance, simplificação de operação e redução do tamanho dos dados. Aqui, na live, apareceu um comentário contando com relatos da experiência de um dos expectadores sobre a melhora da performance quando usado a modelagem dimensional.

Após esse momento, Comaru aponta que o Power Query e o Dataflow não são exemplos – por diversos motivos – de ferramentas de ETL, somente de dowload de dados. Para a solução disso, são apontados o Incremental e o Query Folding por estes eficientes, leves e capacidade em larga escala, contando com modelagem e ingestão na fonte de dados. Aqui apareceu uma questão sobre como resolver o não uso do DW, quando se sobe dados direto do Banco de Dados para o PowerBi; como resposta tivemos: tomar cuidado com a volumetria e criar o DW dentro de views – cuidando com horário do processo por conta da demanda da plataforma.

No meio da live chegamos no ponto de porquê evitar o Dataset Direct Query – spoiler: ele muda o padrão dos dados e consume muito processamento. Próximo ponto: entender DAX! Saber Storage Engine e Formula Engine é fundamental, saber como escrever querys mais eficientes, também. Uma observação ressaltada foi que as funções possuindo o final “X”, servirem para interações.

A próxima dica é evitar o uso de efeitos visuais não oficiais, pois esses podem atrapalhar o desempenho de projetos em grande escala – muitas vezes por não terem sidos criados para esse destino. Quando há um problema de performance e não há uma fonte clara para isso, a indicação do mestre Comaru, é usar o Performance Analyzer do Power Bi para identificar. Após isso, houve a pergunta “As colunas calculadas já devem estar prontas nas tabelas do modelo estrela?” e prontamente o mestre respondeu que sim, que elas já devem ser criadas desde o DW.

Agora, ao falar sobre escalas, especificamente sobre a relação de aumento do volume dos dados e a influencia disso no desempenho; um meio de possuir sempre o melhor desempenho, é desde o início, desenvolver um projeto com uma eficácia de leveza e rapidez. Já que projetos complexos exigem cuidados, esses cuidados são citados nesse momento! Um desses cuidados é “olhar o impacto no todo”, ou seja, observar as origens dos dados, o produto e a entrega.

Chegou o momento de falar sobre as ferramentas aliadas em todo esse processo, o mestre Comaru cita as seguintes: ALM Toolkit – para projetos em enormes escalas, com capacities premium -, DAX Studio – para a criação e otimização de querys -, Tabular Editor – ferramenta de criação, adaptação, tradução e diversas outras funções -, Bravo – um compilado de algumas funções do DAX Studio e do Tabula Editor, com uma interface facilitada -. Após esse momento, foi a hora do chat despejar seus elogios ao mestre e pedidos de um curso direcionado a essa função de otimização do Power Bi.

Chegando nos últimos 10 minutos de live, foi a hora das dicas. A primeira, “esteja sempre atento as novidades”, os canais no YouTube SQLBI e GuyInACube são excelentes para essa função – mas ambos são em inglês. A próxima dica é sempre fazer uma análise de qual ferramenta é a ideal para o projeto a ser desenvolvido, não se baseando somente nas recomendações; outra dica é sempre estudar mais e querer sempre melhorar. A última dica que o mestre Comaru nos dá, é saber sobre Banco de Dados e SQL, pois no mundo do PowerBi, esses dois assuntos tem que estar “na ponta da língua”.

Um último comentário do chat foi sobre o padrão de atualização dever ser incremental no PowerBi, por utilizar menos cpu e memória – em teoria; Comaru acrescentou que o incremental pode ser um anti-herói nesse momento, pois a criação de uma nova query pode ser problemática já que há o aumento de dados – pela duplicação – para uma filtração. Após isso, houve os encerramentos clássicos: elogios a live, a palestra, ao mestre e um breve dialogo sobre a sua formação e sobre o momento onde o mestre conheceu o nosso mestre Thiago.

Na segunda live do dia, o mestre João Ataíde marcou presença! Como de praxe, começamos a live explicando sobre o que é o Comunidade Experience, o que já rolou por aqui e tivemos uma breve apresentação nosso palestrante. Nosso “stalker”, assim como o mestre Thiago chamou o mestre Ataíde, explica que essa procura por produtos na área de dados é sempre constante para aqueles que amam esse assunto.

O assunto dessa live é o Dado Espacial, Metaverso, Realidade Aumentada; tendo a GeoAi como essa grande salada de todos esses assuntos com a união de vários outros. O mestre Ataíde cita que, com esse assunto, é fácil dizer que enfrentamos um novo mundo dos dados, por eles serem uma nova forma de enxergar esse universo de dados – uma forma além do tradicional.

Com GeoAi, o mestre explica – em primeira instancia – o que é a A.I. (artificial inteligence): entender o padrão de oscilação e sinuosidade de um evento, unindo isso com a influência do tempo; além da união da estatística nesse assunto, momento onde o mestre Thiago brilha em um curso onde eles ministram juntos. Aqui, o mestre João cita o Waldo Tobler, criador da Primeira Lei da Geografia, a da similaridade implicada pela distância geográfica; além de citar exemplos de como essa lei é aplicada no mundo cotidiano e de como ela é aplicada na A.I.

Abordando o “geo”, é explicado a geografia e suas áreas como: latitude, longitude, tempo…; e não deixando dever uma ótima explicação de como isso ocorre com a influência da estatística. O próximo ponto é a influência das cercas eletrônicas, ferramenta de análise espacial com diversas funções – uma delas, a usada no exemplo, é a utilização dessas cercas para aviso do aumento da população de macrofilas em um lago monitorado por satélite.

Nesse momento, o mestre João aponta alguns exemplos de dados vetoriais que podem ser usados em análises, dentre eles estão os pontos, as linhas e os polígonos, havendo outros. O próximo assunto é a transformação de dados numéricos em dados tabulares e como trabalhar em cima disso, além de exemplos de fonte de dados (IBGE, INPE, GPS, Satélites, imagens). Um meio de condensar todo o material obtido são as ferramentas; e dentre elas o mestre cita as mais comuns, uma delas é a ArcGIS, nessa ferramenta é possível utilizar o Python e o R com suas extensões e ferramentas combinadas com outras.

Na metade da live, o mestre cita um dos frameworks, criado pelo próprio, sobre o desenvolvimento da A.I. dentro do ArcGIS; desenvolvendo esse assunto, o mestre aponto os detalhes sobre o projeto e suas etapas – estas sendo um circulo, começando e terminando na fase de obtenção de dados, passando em ordem por momentos de: processamento digital de imagem, amostragem, treinamento, inferência e retornando para a obtenção de dados; descrevendo calma e detalhadamente cada etapa, suas funções e suas variáveis. Destacando que o mais importante é saber que a tentativa e erro vai ser a melhor metodologia à aplicar durante todo esse processo.

Chegando nos últimos 20 minutos de live, o mestre aborda as práticas de GeoAi aplicadas em modelos reais, nunca deixando de fora as especificações das classificações de cada uma delas. Aqui houve uma pergunta sobre a relação do mestre com previsões climáticas utilizando esse aspecto da GeoAi, mestre João prontamente responde que já foram desenvolvidos alguns projetos relacionados a isso e que outros ainda estão por vir; já que esse é um assunto que vai se tornar cada vez mais recorrente diante da realidade climática que iremos enfrentar futuramente.

Dentro do aspecto acima, o mestre preparou um slide sobre algumas das funções do GeoAi No slide encontramos os exemplos: classificação, detecção de objetos, trackeamento e mapeamento, previsão de eventos, detecção de anomalias e translation model; o mestre Ataíde não deixa dever e explica a utilidade de cada um desses modelos, bem como a interligação de cada um deles. Ao surgir uma pergunta sobre uma possível existência de um modelo para auxiliar na despoluição de rios, o mestre diz que existem alguns modelos, um deles é sobre um modelo usado no reconhecimento de metais pesados na água; aqui o mestre faz uma analogia com a observação do espaço e sobre as respostas que este nos da, com isso se relaciona a observação da terra e suas respostas.

No momento jabá, aqui é citado o curso dos mestres – o Aprenda GeoAI, bem como o podcast – o Spatial Hackers; aqui rola informações sobre o desconto especial que os alunos da Comunidade tem ao se inscrever nesse curso, bem como a forma de se inscrever no mesmo. Após esse momento, é feito uma explicação breve da ferramenta PowerBi.

Finalizando a live, também finaliza o terceiro dia do Comunidade Experience; mas ainda temos mais de 10 dias de evento e cada dia de evento será resumido aqui no LinkedIn bem como no Blog da nossa queridinha Comunidade de Estatística, não deixem de dar uma olhada em todas nossas redes para ficar por dentro de cada artigo sobre o evento e de todas as novidades. Vamos juntos!

- Categoria(s): Dicas e Eventos